EU AI Act 2025 - Ein 8 Schritte Compliance Fahrplan

Einleitung

Am 2. August 2025 werden die neuen Anforderungen des EU-KI-Gesetzes für KI-Modelle für allgemeine Zwecke (GPAI) rechtskräftig. Von diesem Tag an müssen Entwickler, Vertreiber und Betreiber von KI, deren Ergebnisse EU-Nutzer erreichen, Transparenz, Dokumentation und Sicherheit nachweisen - oder sie riskieren Geldstrafen von bis zu 35 Millionen Euro oder 7 Prozent des weltweiten Umsatzes. Dieser Leitfaden führt Sie auf einem schnellen Weg zur Compliance-Reife, erklärt, warum auch Schweizer Unternehmen davon betroffen sind, und listet die Fragen auf, die bei der Auswahl eines KI-Anbieters unbedingt gestellt werden müssen. Compliance, richtig gemacht, wird von einer Kostenstelle zu einem mächtigen Vertrauens- und Umsatzhebel.

Eine ausdruckbare 8-stufige Checkliste und eine Scorecard zur Selbsteinschätzung, laden Sie unseren kostenlosen EU AI Act Leitfaden herunter.

Warum der zweite August 2025 eine harte Deadline ist

Das Gesetz ist im August 2024 in Kraft getreten, doch werden die Sanktionen für GPAI-Modelle erst am 2. August 2025 wirksam. Ab diesem Zeitpunkt können die Aufsichtsbehörden bei Nichteinhaltung der Vorschriften Geldbußen von bis zu 35 Mio. EUR oder 7 % des weltweiten Umsatzes verhängen.

Wer ist davon betroffen - auch ausserhalb der EU?

Das Gesetz ist im August 2024 in Kraft getreten, doch werden die Sanktionen für GPAI-Modelle erst am 2. August 2025 wirksam. Ab diesem Zeitpunkt können die Aufsichtsbehörden bei Nichteinhaltung der Vorschriften Geldbußen von bis zu 35 Mio. EUR oder 7 % des weltweiten Umsatzes verhängen.

"Schweizer Sicht: Ein Schweizer KMU fällt immer dann unter das Gesetz, wenn seine KI-Outputs Auswirkungen in der EU haben, z. B. ein HR-Bot, der Kandidaten für eine Stelle in der EU bewertet, eine Exportmaschine, die KI-Vision in einer EU-Fabrik einsetzt, oder ein SaaS-Tool, das EU-Kunden bedient."

Source: https://www.lexr.com/en-ch/blog/regulatory-updates-for-startups-in-2025/

Die vier Risikoklassen auf einen Blick

| Class | Typische Beispiele | Praktisch zum Mitnehmen |

|---|---|---|

| Unacceptable | Erkennung von Emotionen bei Mitarbeitern in Echtzeit | Völlig verboten |

| High risk | HR-Screening, sicherheitskritische Bildverarbeitung | CE-ähnliche Konformität, strenge Audits |

| Limited risk | Chat & Sprachroboter | Muss "KI-Assistent" offenlegen (Art. 50) |

| Minimal risk | Allgemeine Büroautomatisierungen | Freiwilliger Verhaltenskodex |

Benötigen Sie einen Stufenplan, nachdem Sie die Risikoeinstufungen gesehen haben?

Die Matrix zeigt, was das Gesetz vorschreibt - unser kompakter Leitfaden zur Einhaltung des EU AI Act erklärt, wie und wann zu handeln ist:

- 8-stufiger Fahrplan, der jeden Rechtsartikel einer konkreten Aufgabe zuordnet

- 5-minütige Scorecard zur Selbsteinschätzung

- Bearbeitbare Excel-Vorlage für Ihr KI-Inventar und Risikoprotokoll

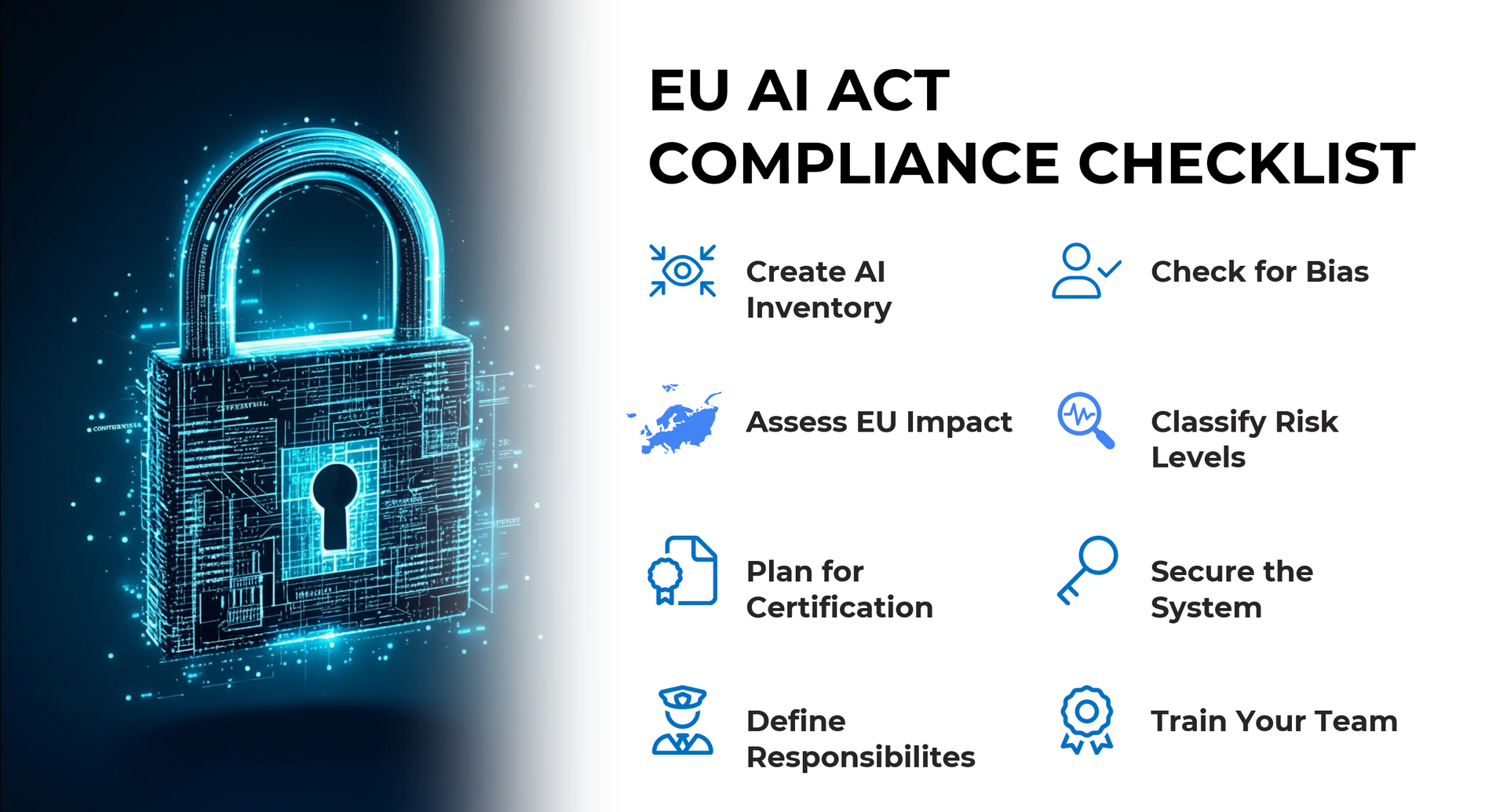

Der 8-Schritte-Schnellkurs zur Einhaltung der Vorschriften

- Erstellung eines KI-Inventars - Auflistung aller Modelle und Anwendungsfälle.

- Bewertung der Auswirkungen auf die EU: Erreichen die Ergebnisse die Nutzer in der EU? Extraterritorialität ist wichtig.

- Klassifizierung des Risikos - Anwendung der oben genannten vierstufigen Matrix.

- Planen Sie die Zertifizierung - bereiten Sie Dokumentation, Transparenzhinweise und (bei hohem Risiko) einen Konformitätsfahrplan vor.

- Prüfung auf Verzerrungen - Durchführung quantitativer Fairness-Tests, Aufzeichnung der Ergebnisse und Einrichtung einer kontinuierlichen Überwachung.

- Sichern Sie System und Protokolle - Datenqualitätsprüfungen, Cyber-Hardening, manipulationssichere Audit-Protokolle.

- Schulen Sie Ihr Team - rollenbasierte KI-Kenntnisse; verpflichtender Nachweis seit dem 2. Februar 2025.

- Definieren Sie Verantwortlichkeiten - ernennen Sie einen KI-Beauftragten oder legen Sie klare Berichtslinien fest (Art. 4).

Reality check: Können Sie in weniger als fünf Minuten die Risikoklasse, die Datenherkunft und das letzte Auditprotokoll für jedes Modell erstellen? Wenn nicht, beginnen Sie mit Schritt 1.

Die wichtigsten Erkenntnisse aus unseren Webinaren zum EU-KI-Gesetz

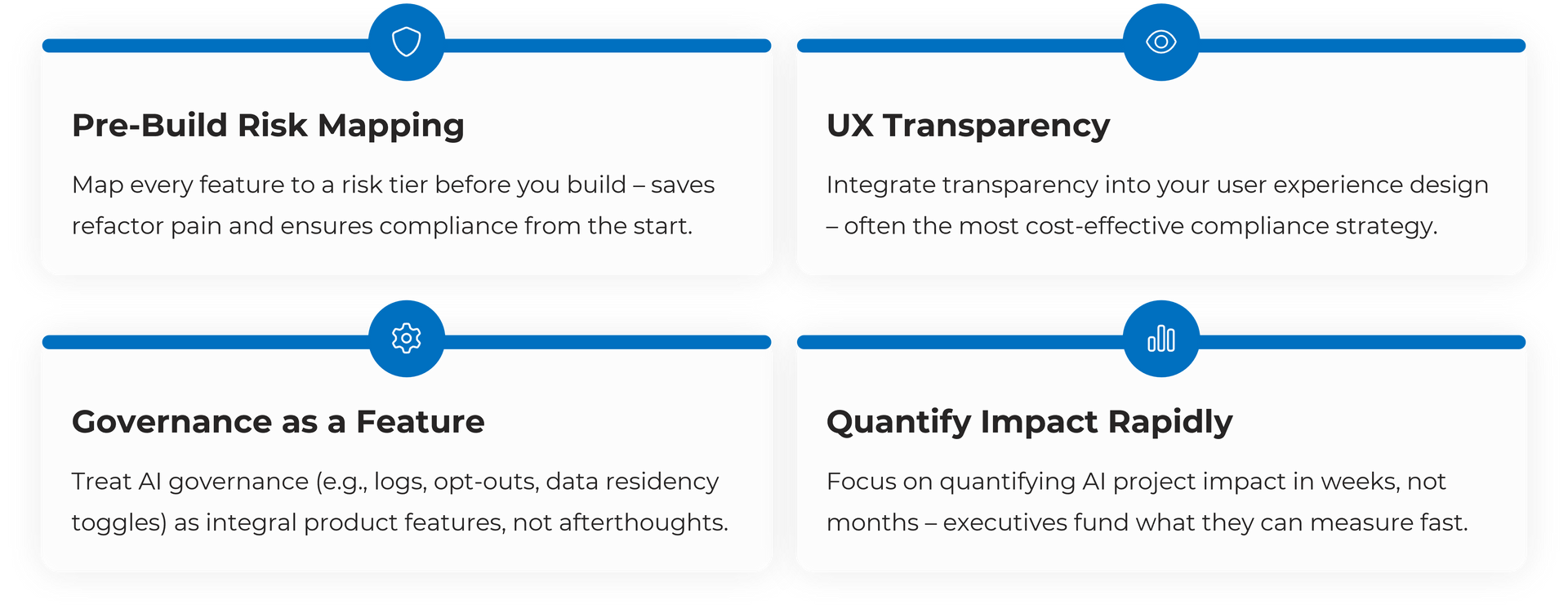

1) Eine Risikokartierung

vor der Entwicklung vermeidet spätere kostspielige Umstrukturierungen.

2) UX-Transparenz schlägt Bussgelder

- ein einfacher "KI-Assistent"-Badge erfüllt oft Art. 50 für Bots mit begrenztem Risiko.

3) Governance verkauft sich gut - Audit-Protokolle, Opt-outs und Datenresidenzschalter sind keine Bürokratie, sondern gewinnen das Vertrauen der Kunden..

Checkliste für die Anbieterauswahl und wie dreamleap abschneidet

5 Fragen, die man bei der Auswahl eines Anbieters stellen muss

- Hält sich der Anbieter an die Vorschriften für die Erstellung von AI-Modellen?

- Stellt der Anbieter eine umfassende Dokumentation der Daten/Modelle zur Verfügung?

- Eingebaute Überwachung von Verzerrungen und Robustheit?

- Manipulationssichere Prüfprotokolle?

- Gibt es KI-Schulungen für Ihre Teams?

Fazit

Der Countdown läuft. Ein klares Acht-Schritte-Programm - und ein Partner, der die Kriterien erfüllt - verwandelt den 2. August 2025 von einem Schreckgespenst der Compliance in eine Zukunft für vertrauenswürdige, skalierbare KI.

➜ Download: EU AI Act Compliance Guide

➜ Melden Sie sich für das Webinar an - vollständige Fragen und Antworten und Folien

➜ Buchen Sie einen Use-Case Ideation Workshop - bilden Sie Ihre Prozesse mit dem AI-Act ab

dreamleap begleitet Sie vom ersten Risiko-Scan bis zum prüfungsreifen Bericht - damit Sie mit Zuversicht innovieren können.

Warum wird dreamleap AI von vielen SMBs genutzt?

dreamleap verfügt über einen intelligenten Abrufmechanismus, der auf LLMs, RAG, Agentenkomponenten und fortschrittlichen KI-Engineering-Modellen und -Mechanismen basiert, die keine Daten außerhalb der EU verarbeiten.

dreamleap bietet bereits viele Top-KI-Agenten out of the box, mit einem starken Fokus auf Geschäftswert, Enablement, Daten-Compliance und Sicherheit, kombiniert mit flexiblen Hosting-Optionen und erschwinglichen Preisen für KMUs.

Wie sieht es mit Microsoft Copilot vs. ChatGPT OpenAI aus?

MS Copilot bietet jedoch mehr Sicherheit bei der Datenverarbeitung für EU-Unternehmen: "Microsoft 365 Copilot-Anrufe an das LLM werden an die nächstgelegenen Rechenzentren in der Region weitergeleitet, können aber in Zeiten hoher Auslastung auch in andere Regionen gehen, in denen Kapazitäten verfügbar sind." Alle wichtigen Informationen finden Sie hier: https://learn.microsoft.com/en-us/copilot/microsoft-365/microsoft-365-copilot-privacy

Eine gute Übersicht finden Sie hier: https://www.rosenthal.ch/downloads/VISCHER_ki-tools-03-25.pdf

Worauf muss ich bei der Bewertung von KI-Anbietern achten?

Prüfen Sie zunächst immer bei einem Anbieter, ob er die OpenAI GPT API direkt verwendet. Wenn dies der Fall ist, können Ihre Daten nach den neuen Änderungen zur Vorratsdatenspeicherung gefährdet sein.

Überprüfen Sie zweitens, ob die Anbieter ihre KI-Lösungen auf bestehenden Plattformen aufbauen (wie Crew AI, n8n, Make oder Lovable). Wenn ja, klären Sie, ob diese Tools für die Verwendung in Ihrem Unternehmen zugelassen sind. Viele von ihnen verarbeiten Ihre Daten extern und benötigen proaktiv Zugriff auf Ihre Daten, was bei hochsensiblen Informationen möglicherweise nicht angebracht ist.

Drittens: Wenn Sie interne Daten für Ihre KI-Anwendungen verwenden müssen, stellen Sie sicher, dass Sie mit einem Anbieter wie creamleap zusammenarbeiten, der dedizierte Modelle anbietet, die in Ihrer eigenen Cloud- oder On-Premises-Umgebung gehostet werden.

Wenn Sie ein KMU sind oder mit nicht sensiblen Daten arbeiten (d. h. keine strategischen, personenbezogenen Daten oder vertraulichen Inhalte) und wenn die Daten außerhalb der EU verarbeitet werden oder das Tool selbst darauf zugreifen kann, kann die Verwendung von ChatGPT oder ähnlichen Diensten akzeptabel sein.

dreamleap ist ideal, wenn Sie ein Maximum an Sicherheit und Flexibilität wünschen, um Ihre eigenen Daten zu integrieren, auch neben Tools von Drittanbietern, und dabei die volle Kontrolle zu behalten.

Glossar und weiterführende Literatur

| Term | Kurze Erklärung |

|---|---|

| GPAI (General-Purpose AI model) | Ein breit ausgebildetes Modell, das sich an viele nachgelagerte Aufgaben anpassen lässt; unterliegt den Art. 53-55 Transparenzpflichten. |

| Risk-class matrix | Vier rechtliche Stufen - inakzeptabel, hoch, begrenzt, minimal - bestimmen, welche Kontrollen gelten. |

| Model Card | Standard-"Pass", der den Zweck eines Modells, die Datenherkunft, die Metriken, die Grenzen und die ethischen Risiken beschreibt (für GPAI erforderlich). |

| Code of Practice (CoP) | Freiwillige, aber erwartete Basiskontrollen, die GPAI-Anbieter unterzeichnen, um gute Praktiken zu demonstrieren (Art. 54). |

| Conformity assessment | CE-ähnliches Verfahren (Prüfung, Dokumentation, benannte Stelle) für AI-Systeme mit hohem Risiko vor der Markteinführung vorgeschrieben. |

| AI Literacy (Art. 4) | Nachweis, dass das Personal im sicheren und ethischen Umgang mit KI geschult ist; seit dem 2. Februar 2025 obligatorisch. |

| Bias & Fairness metrics | Quantitative Tests (z.B. demographische Parität, Equalized Odds), die systematische Leistungsunterschiede aufzeigen. |

| Manipulationssichere Prüfprotokolle | Unveränderliche, mit Zeitstempel versehene Aufzeichnungen von Modellaufrufen, Aufforderungen und Ausgaben - durchsetzbar für systemische GPAI (Artikel 55). |

| Incident reporting | 72-Stunden-Meldung an das EU-Büro für künstliche Intelligenz, wenn eine Verletzung der Sicherheit oder der Rechte im Zusammenhang mit künstlicher Intelligenz auftritt (Art. 62). |

| AI Officer | Benannte Person, die für das Risikoregister, den Nachweis der Einhaltung der Vorschriften und den Kontakt zu den Aufsichtsbehörden verantwortlich ist. |

| Guardrails | Technische und politische Kontrollen (Prompt-Filter, PII-Maskierung, Ratenbegrenzungen), die unsichere oder nicht konforme Modellergebnisse verhindern. |

| Extraterritoriality | Grundsatz, dass Nicht-EU-Unternehmen gebunden sind, wenn ihre KI-Ergebnisse innerhalb des EU-Binnenmarkts verwendet werden. |